Применимость зарубежных подходов к ранжированию в высшем образовании в России

Баринова В.А.1, Еремкин В.А.1, Земцов С.П.1

1 Российская академия народного хозяйства и государственной службы при Президенте Российской Федерации, г. Москва, Россия, Москва

Скачать PDF | Загрузок: 41 | Цитирований: 1

Статья в журнале

Креативная экономика (РИНЦ, ВАК)

опубликовать статью | оформить подписку

Том 10, Номер 3 (Март 2016)

Эта статья проиндексирована РИНЦ, см. https://elibrary.ru/item.asp?id=25450231

Цитирований: 1 по состоянию на 07.12.2023

Аннотация:

В данной работе проанализированы основные международные подходы к построению рейтингов высшего образования и дана оценка их применимости для сопоставления российских вузов.

Ключевые слова: высшее образование, образовательная политика, рейтинги вузов, 5-100, университеты России

Введение

Существуют десятки международных рейтингов вузов (Балацкий, Екимова, 2011; Салми, Фрумин, 2007), каждый из которых имеет определенное влияние на выбор абитуриентов [1], а значит, и на востребованность вузов [2]. Перед Правительством Российской Федерации стоит задача создания конкурентоспособной и эффективной системы высшего образования, способной обеспечить страну кадрами высшей квалификации, в первую очередь, технических специальностей для модернизации отечественных производств и инфраструктуры.

Не менее важной задачей является и повышение востребованности российских вузов с точки зрения привлечения зарубежных студентов. Поэтому Правительство увеличило в 2015 году поддержку наиболее эффективных вузов для повышения их позиции в международных рейтингах: из федерального бюджета в рамках государственной программы «Развитие образования на 2013–2020 годы» выделено 10,14 млрд рублей субсидий 14 вузам, из которых 7 относятся к техническим. При этом принято решение изменить основные целевые ориентиры программы: теперь необходимо войти в 100 лучших вузов в рейтингах Times Higher education, ARWU и QS по отдельным предметным областям.

Международные рейтинги вузов

Идея глобального ранжирования университетов восходит ко второй половине 1990-х годов, когда было положено начало первому международному рейтингу [3]. Большинство современных рейтингов высших учебных заведений глобального или национального масштабов составлены таким образом, что они стремятся дать оценку вузу целиком или отдельному направлению его деятельности. При этом рейтинги вузов, в основном, не детализированы до степени анализа образовательных программ.

Объектом исследования для составителей рейтингов служит предварительно цензурированная выборка, поскольку охватить более 21 тыс. вузов не представляется возможным. В выборку обычно входит от тысячи до 6 тысяч университетов, лучшие из которых попадают в финальный рейтинг. Методика рейтингов ориентирована на ведущие университеты мира.

Наиболее популярным и авторитетным в мире принято считать три рейтинга: QS, Times Higher Education и ARWU.

При этом существующие рейтинги не лишены недостатков:

- Цитирование свидетельствует о популярности ученых, но не всегда отражает качество исследований и преподавания. При этом популярность авторов очень сильно зависит от популярности темы.

- Существуют недостатки системы рецензирования в журналах.

- Сохраняются национальные традиции научного цитирования. Разные отрасли знаний имеют разную научную цитируемость.

- Высокая чувствительность импакт-фактора и индекса Хирша.

- Избыточная роль научных обзоров и статистических сборников для системы цитирования.

- Возможны манипуляции со статусом иностранных студентов и профессоров.

- Разные определения ставок преподавателей и наличие разных форм обучения студентов, ведущее к различной оценке соотношения преподавателей и студентов в разных странах.

- Недоучет эффекта масштаба университета, влияющего на его узнаваемость, популярность и престижность.

- Эффект избыточного доверия вузам при сборе информации.

Использование рейтингов для серьезных оценок и принятия решений на государственном уровне не всегда представляется возможным. Практическая реализация программ по изменению положения университетов в таких рейтингах может свестись, например, к привлечению в вузы большего числа нобелевских лауреатов или иностранных специалистов.

Увеличение числа публикаций, с одной стороны, может рассматриваться как позитивное изменение, но, с другой стороны, может свестись к простому приращению числа статей в базах Web of Science или Scopus и уходу от публикаций в книгах и других журналах. Стремление улучшить позиции в рейтинге может привести к смещению акцентов в сторону технических, экономических и медицинских наук в ущерб гуманитарным и социальным наукам (это касается и стремления повысить цитируемость). Рабочая группа AUBR [4] утверждает, что даже библиометрические индикаторы могут быть некорректными из-за манипуляции данными.

Показатели по всем индикаторам, которые связаны с исследовательским или преподавательским составом, даже если они рассчитывались по эквиваленту полной занятости, могут содержать в себе искажения, связанные с различным определением категорий персонала. Например, показатель соотношения числа студентов и сотрудников вуза при использовании одних и тех же данных может варьироваться от 6:1 до 39:1 [5]. Возможны манипуляции с трудовыми отношениями между сотрудниками и вузов в угоду высоких показателей в рейтингах.

Показатель, отражающий численность иностранных студентов и преподавателей, может также быть использован для различных манипуляций. Кроме того, нет четкого определения, кого стоит считать иностранным студентом или преподавателем.

Некоторые рейтинги оценивают при помощи индикаторов совокупного продукта (совокупного числа нобелевских лауреатов, статей, цитирований и т.д.). Укрупнение университетов может приводит к существенному улучшению этих показателей, а соответственно, и положения вуза в рейтинге.

Существует определенное число случаев, когда университеты действительно занимались улучшением своих позиций за счет работы с определенными индикаторами рейтинга. Некоторые институты прилагали большие усилия для того, чтобы мотивировать студентов подавать документы на поступление, завышая таким образом показатели конкурса.

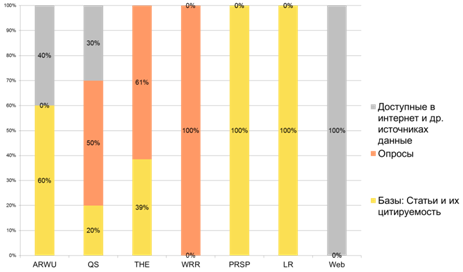

Анализ источников сбора данных по ряду международных рейтингов показывает, что в них часто используются закрытые данные и результаты экспертных опросов, что ведет к невозможности их верификации (рис. 1).

Рисунок 1. Источники данных ведущих рейтингов

Источник: составлено авторами по данным рейтингов

Если рейтинг включает опросные данные, касающиеся репутации вуза, то результаты сильно зависят от методики анализа результатов, и также существует вероятность манипуляции результатами [6]. По этой причине, например, CHE University Ranking исключает из своих оценок какие-либо опросы академического сообщества.

Рейтинги охватывают лишь некоторые функции университета. Отсутствие подходящих индикаторов является наиболее очевидным при попытке измерить качество университетского обучения. Оценка научно-исследовательской работы более разнообразна, хотя и библиометрические показатели не лишены недостатков.

Сегодня трудно утверждать, что преимущества, которые заключаются в информации, предоставляемой рейтингами, превышают негативные нежелательные последствия, как, например, стремление вузов изменить свое положение в рейтинге за счет манипулирования отдельными показателями.

Разработка рейтинга мировых вузов не останавливается, и постоянно ведутся работы по улучшению и обновлению старых рейтингов, а также созданию новых. Однако слишком рано говорить о каких-либо прорывах в этой области, поскольку основные проблемы остаются нерешенными: проблемы сбора данных, разработки новых методов оценки, расширения статистической базы. Поэтому в современных условиях образовательная политика не должна основываться исключительно на данных рейтингов, которые являются лишь вспомогательными показателями.

Для абитуриентов часто важна не позиция вуза в общем рейтинге, а его положение по отдельным индикаторам. Поэтому популярными становятся рейтинги с многомерным ранжированием, к которым в частности относится U-Multirank, принятый в 2011 гг. Еврокомиссией для достижения целей по повышению прозрачности в работе вузов и научно-исследовательских институтов. Рейтинг также оценивает показатели отдельных научных областей: бизнес-исследования, электротехника, машиностроение и физика; психология, информатика и медицина. Университеты проверяются по 30 отдельным показателям и оцениваются в пяти группах эффективности от A (очень хорошо) до E (слабо).

Заключение

1. Для оценки качества образования в вузах в настоящее время используется целый ряд международных и российских рейтингов, однако большинство из них ориентировано на крупные и известные университеты. Они также имеют недостатки в методиках сбора статистики и в самой процедуре составления, которые активно критикуются. При этом ориентация на попадание российских вузов в международные рейтинги приводит к необходимости ускоренной модернизации и финансовой поддержки наиболее эффективных технических вузов.

2. Большинство зарубежных рейтингов вузов характеризуются определенными недостатками: чрезмерно большой набор индикаторов, что вызывает сложности в построении рейтинга и в ходе верификации, а также затрудняет интерпретацию результатов. Критике также подвергаются:

– выбор индикаторов, включая чрезмерное значение показателей цитируемости, которая может быть связана с популярностью вуза;

– наличие разных национальных и отраслевых традиций научного цитирования;

– разные критерии расчета полной ставки преподавателей и приведенного контингента студентов и др.

3. Многие рейтинги не ссылаются на общепринятую методику оценки, а при сборе статистики попадают под влияния эффекта избыточного доверия вузам и экспертам.

4. Многие рейтинги зависят от мнений экспертов, студентов и выпускников, рекрутеров, поэтому нельзя избежать конъюнктурности и субъективности оценок, которые одновременно с этим еще и сильно зависят от уже существующих и известных экспертам рейтингов. Подходы в значительной мере ориентированы на оценку научно-исследовательской составляющей, что слабо применимо для оценки вузов России в виду иных функций и недостатка информации.

[1] Ефимова, Маковейчук, 2014; Павлюткин, 2010; Clarke, M. (2007). The Impact of Higher Education Rankings on Student Access, Choice, and Opportunity. Higher Education in Europe. 32(1), 59-70. doi: 10.1080/03797720701618880; Hazelkorn, E. (2007). The Impact of League Tables and Ranking Systems on Higher Education Decision Making. Higher Education Management and Policy, 19(2), 81–105. doi: 10.1787/hemp-v19-art12-en

[2] Земцов, С.П., Еремкин, В.А., Баринова, В.А. (2015). Что влияет на востребованность ведущих вузов России?. Ректор вуза, 7, 28–35.

[3] Hazelkorn, E. (2007). The Impact of League Tables and Ranking Systems on Higher Education Decision Making. Higher Education Management and Policy, 19(2), 81–105. doi: 10.1787/hemp-v19-art12-en

[4] European Commission. (2010). Assessing Europe’s University-Based Research: Expert Group on Assessment of University-Based Research. Retrieved from: https://ec.europa.eu/

[5] Baty, P. (2010, May 27). THE World University Rankings // Times Higher Education World University Rankings.

[6] European Commission. (2010). Assessing Europe’s University-Based Research: Expert Group on Assessment of University-Based Research. Retrieved from: https://ec.europa.eu/

Страница обновлена: 26.01.2026 в 23:21:43

Download PDF | Downloads: 41 | Citations: 1

The applicability of foreign approaches to ranking in the higher education system of Russia

Barinova V.A., Eremkin V.A., Zemtsov S.P.Journal paper

Creative Economy

Volume 10, Number 3 (March, 2016)

Abstract:

The paper analyzes the main international approaches to higher education rankings and assesses their applicability for the purpose of comparing Russian universities.

Keywords: higher education, educational policy, rankings of higher educational institutions, 5-100, Russian universities