Моделирование развития и внедрения систем «слабого» и «сильного» искусственного интеллекта: социально-экономические аспекты

Городнова Н.В.1

1 Уральский федеральный университет им. первого Президента России Б.Н. Ельцина, Россия, Екатеринбург

Скачать PDF | Загрузок: 71 | Цитирований: 3

Статья в журнале

Вопросы инновационной экономики (РИНЦ, ВАК)

опубликовать статью | оформить подписку

Том 12, Номер 1 (Январь-март 2022)

Эта статья проиндексирована РИНЦ, см. https://elibrary.ru/item.asp?id=48333780

Цитирований: 3 по состоянию на 07.12.2023

Аннотация:

Процесс реализации национальной программы «Цифровая экономика Российской Федерации» сопровождается активным внедрением алгоритмов искусственного интеллекта (ИИ) в различные сферы отечественной экономики. В этой связи тема научного исследования признается актуальной и злободневной.

Цель данной статьи состоит в выявлении и изучении социально-экономических и этических аспектов включения алгоритмов искусственного интеллекта в жизнедеятельность человека (индивида) и общества в целом. Научная новизна заключается в разграничении дефиниции «слабого» и «сильного» искусственного интеллекта, развитии понятийно-категориального аппарата путем уточнения отдельных определений, а также применении отдельных подходов экономико-математического моделирования в прогнозировании уровня включения возможностей ИИ в человеческое общество.

Практическая значимость исследования состоит в определении факторов, сдерживающих разработку так называемого «сильного» искусственного интеллекта (сверхинтеллекта), а также в идентификации социально-экономических и этических проблем внедрения ИИ в различных сферах социально-экономической жизни. Результаты научного исследования могут быть полезными специалистам в it- и бизнес-сферах, а также ученым, занимающимся экономическими, социо-гуманитарными и этическими проблемами расширенного воспроизводства систем искусственного интеллекта.

Ключевые слова: искусственный интеллект, морфогенез, нейронные сети, этика, трансакционные издержки, рынок труда, самообучение

JEL-классификация: O31, O32, O33

ВВЕДЕНИЕ

С развитием процессов цифровизации экономики, существенно ускорившихся в условиях распространения новой коронавирусной инфекции, разработка и включение в общественные и производственно-финансовые сферы алгоритмов искусственного интеллекта (ИИ) приобретают еще большую актуальность. Дискуссии между экспертами и специалистами по проблематике адаптации человека и общества к цифровой среде и внедрения ИИ продолжаются. Противоборство оптимистов и пессимистов, которые выражают собственное научное мнение по заявленной тематике, не прекращается. Полемика ведется, прежде всего, по вопросам защиты человека и адаптации всего общества к новой цифровой среде реализации экономических процессов.

Реализация национальной программы «Цифровая экономика в Российской Федерации» открывает широкие перспективы разработки и внедрения инновационных продуктов IT-технологий, создания и применения больших баз данных и алгоритмов искусственного интеллекта. Однако следует отметить, что данный процесс сопряжен с возникновением различных рисков социально-этического характера практически для всех членов общества. К примеру, до сих пор на повестке дня этический вопрос о сборе, анализе и обработке больших баз данных с социальной и персональной информацией граждан РФ. Под данными следует понимать унифицированные сигналы, которые поступают с различных датчиков smart-устройств, применяемых в технологических циклах реального сектора экономики, сельском хозяйстве, бизнесе, в сфере оказания государственных и частных услуг народонаселению страны, а также носимых устройств (смартфонов и планшетов). Указанные данные необходимы для осуществления обучения алгоритмов искусственного интеллекта, для реализации интернет-торговли и осуществления онлайн-рекламы. Для государства указанные данные граждан являются основанием для принятия управленческих решений, для электронного взаимодействия государства и человека, для обеспечения национальной безопасности.

В таких условиях перед государством остро стоит вопрос обеспечения гарантий основных прав человека как общее условие для подлинно частного существования индивида в цифровой сфере.

Процесс обучения алгоритмов искусственного интеллекта должен учитывать такие этические сферы, как исключение непреднамеренного создания программных продуктов и систем принятия решений, дискриминирующих отдельные группы населения вследствие недостаточной тщательности сбора и обработки данных, конфликт интересов общества в целом и отдельных групп граждан, неверных государственных решений с далекоидущими последствиями в форме репутационных и финансовых потерь государства, а также непреднамеренное нарушение российского законодательства вследствие неэтического использования персональных данных граждан, повлекшего значительный ущерб конкретному человеку, группе лиц или обществу в целом.

В разрезе указанных проблем и проводилось данное научное исследование, посвященное прогнозированию возможных социально-экономических и этических проблем в процессе моделирования процессов разработки и внедрения алгоритмов «слабого» и «сильного» искусственного интеллекта.

Дефиниции «сильного» и «слабого» искусственного интеллекта

Сегодня в науке под искусственным интеллектом (ИИ) понимаются программы, системы и алгоритмы, предназначенные для решения интеллектуальных задач, т.е. тех задач, которые решаются людьми при помощи собственного (естественного) интеллекта [1] (Bykov, 2020). Специалисты в области IT-технологий и электроники осознанно уходят от определения дефиниции «интеллект», потому что до появления систем ИИ единственно существующим примером интеллекта был человеческий интеллект, а это означает, что определить указанный термин на единственном примере, с точки зрения научного и системного подхода, не является корректным [2, c. 44] (Vorontsova, Lukonina, 2020, р. 44).

Специалистами в сфере создания и внедрения систем ИИ на сегодняшний день осуществляется разграничение двух смежных понятий искусственного интеллекта. Ими выделяется прикладной ИИ (слабый ИИ, узкий ИИ) – это системы искусственного интеллекта, предназначенные для решения какой-то одной задачи или небольшого множества достаточно простых задач [1]. Примерами таких видов ИИ являются алгоритмы и системы для игры в шахматы, распознавания речи и образов, процесса принятия решения о предоставлении кредита, различные электронные помощники и т.п.

Ко второму виду искусственного интеллекта, который обозначается как универсальный ИИ (сильный ИИ), или сверхинтеллект, относятся системы, базирующиеся на глубоком обучении нейронных сетей в целях решения многофакторных и многоуровневых проблем. Сильный ИИ – это гипотетическая возможность разработки самообучающегося машинного алгоритма, который будет способен решать любые заданные интеллектуальные задачи любой сложности. Создаваемые сегодня программные продукты с помощью необходимой интерпретации указанных понятий заинтересованных кругов достаточно легко могут быть отнесены как к первому виду ИИ, так, при желании, и ко второму.

Подчеркиваем, что внедренные к середине 2021 года различные программные и алгоритмические продукты и системы, к примеру различные чат-боты, интеллектуальные помощники типа Алиса (компания «Яндекс»), «Салют» (экосистема «Сбер»), финансовый ассистент Олег (интернет-банк «Тинькофф») и т.п. – это примеры так называемого слабого искусственного интеллекта и прикладных систем. Указанные прикладные системы в ряде случаев способны решать интеллектуальные задачи по сравнению с человеческим естественным интеллектом быстрее и качественнее. Так называемого сильного ИИ, способного решать сложные многогранные интеллектуальные проблемы, к настоящему моменту человеческой мыслью не создано. Еще одно серьезное заблуждение, по мнению ученых, занимающихся развитием искусственного интеллекта, – это непременное условие наличия у систем ИИ способности к самообучению через нейронные сети [2].

Следует отметить, что машинное обучение на основании нейронных сетей – это отдельная научная сфера, позволяющая осуществлять обучение программного обеспечения решению различных интеллектуальных задач. Специалисты выделяют несколько типов машинного обучения нейронных сетей: обучение с учителем, обучение без учителя, а также обучение с подкреплением [3]. В первом типе обучающего алгоритма – обучение с учителем (supervised leaning) – предполагается наличие набора некоторого количества условно правильных решений для некоторого набора случаев. В идеале должен быть в наличии полный набор уже размеченных исходных данных для тренировки алгоритмической модели на всех уровнях и этапах ее разработки [5] (Zhilin, Safaryan, 2020). Это означает, что в обучающей системе каждому примеру точно соответствует ответ, который алгоритмическая модель должна получить. Задача такого обучения заключается в том, чтобы машинный алгоритм обучался на основе уже располагаемых примеров принимать верное решение в иных, неизвестных и неопределенных условиях и ситуациях.

Во втором случае – обучение без учителя (unsupervised leaning) – означает, что размеченных и чистых баз данных нет вообще или они недостаточно очищены от информационных искажений, шумов и помех, т.е. данные представлены в сыром, неочищенном виде, поэтому перед алгоритмом стоит задача поиска правильного решения в условиях, когда верные ответы заранее не определены. В таком случае алгоритм (нейросеть) должен самостоятельно найти корреляцию в исходных данных, выделить полезные для обучения признаки и проанализировать их. Примером такого вида обучения без учителя является способность машинного алгоритма выявлять семантические отношения между отдельными словами языка, опираясь на анализ огромного набора текстов.

Третий тип обучения – обучение с подкреплением (reinforcement learning) – специалистами отнесен к разновидному обучению машины с учителем. Особенностью рассматриваемого вида обучения ИИ является процесс, в котором искусственный интеллект является агентом, помещенным в определенную, смоделированную среду, в которой он может взаимодействовать с другими аналогичными агентами (к примеру, с собственными копиями) и получить от них в режиме обратной связи определенную реакцию, выражаемую в виде стимулов или вознаграждений. Такой тип обучения ИИ применяется, как правило, в довольно широком перечне видеоигр или в программных алгоритмах игры в шахматы, где шахматные программы играют сами с собой, постепенно обучаясь и повышая качество игры и результативность. Следует отметить, что такой тип обучения имеет весьма широкую область применения и обучения ИИ, включающую множество различных методов, постепенно и неуклонно усиливающих алгоритмы ИИ.

Особое место в линейке типов обучения ИИ занимает обучение ИИ с частичным привлечением учителя (semi-supervised learning). Этот способ обучения нейросетей – нечто среднее между обучением с учителем и без учителя. Метод базируется на формировании датасетов как с очищенными и размеченными, так и с неочищенными и неразмеченными исходными данными. Указанный метод машинного обучения ИИ применяется, как правило, в целях анализа различного рода медицинских изображений (сканов компьютерной томографии (КТ) или МРТ) [4].

Существует позитивный опыт использования слабого ИИ без способности к самообучению (смартфонов, различных видеоигр, дронов (беспилотников), социальных сетей, устройств умного дома, систем наблюдения и безопасности, банковских помощников и платформ), способных выполнять работу по сравнению с сотрудником-человеком гораздо лучше и эффективнее. Однако возможность к самообучению многие системы ИИ обрели около 50 лет назад. Примерами таковых могут быть текстовые редакторы Cyborg Writer, Talk to Books (Google Al), интеллектуальная система для рисования Quicl, Draw!, различные интеллектуальные приложения для смартфонов и пр.

В решении вопроса построения систем так называемого сильного искусственного интеллекта лежит ключевая проблема отграничений двух терминов «разум/интеллект» и «понимание». У первого термина может быть достаточно разнообразное толкование: что такое «человеческий разум» и какими свойствами должен обладать его имлементация на искусственном носителе? [5]

У второй дефиниции «понимание» – что есть «семантика» с точки зрения непосредственно самого естественного разума?

Вопрос о возможной «разумности» машин был поставлен специалистами по разработке электронно-вычислительных машин (ЭВМ) еще в 30-е годы ХХ века. Первым результатом на пути к пониманию уровня разумности ЭВМ стала программа ELIZA, которая была создана в 1966 году [6]. Название программы было взято по имени героини пьесы Б. Шоу «Пигмалион». Программа была написана таким образом, что она имитировала процесс принятия решения не просто человеком, а специалистом-психиатром. Программа ELIZA представляет собой огромный набор правил, по которому она находила определенные паттерны поведения человека (пациента) по его письменной речи.

Однако следует добавить, что письменные ответы алгоритма ELIZA напоминали, скорее всего, пародию на медицинское заключение специалиста в области психиатрии, поскольку в ответ на входящую информацию данная программа после определенной трансформации информации генерировала выходную информацию, которая представляла собой набор специфических жаргонных психиатрических терминов. Проведенная серия экспериментов с программой ELIZA, прообразом чат-бота, показала определенные результаты и дала возможность продвижения в данном научном направлении.

Второй программой подобного рода является алгоритм PARRY, написанный в 1972 году К. Колбаем (Стэнфордский университет). Данный алгоритм является продолжением идей программы ELIZA, однако существенным отличием в принципиальном подходе программного продукта PARRY является то, что последний был призван имитировать поведение пациента психиатрической клиники. В результате эксперимента 48% врачей-психиатров не смогли отличить формулировки программы от человеческого поведения [7].

Изучение достаточно широкого ряда экспертных мнений специалистов в области создания искусственного интеллекта [7, 8] (Lapaev, Morozova, 2020; Lyubimov, 2020), позволило сделать один из главных выводов, что в настоящий момент человечество занимает прочные позиции и получает результаты исключительно в области разработки «слабого» (узкого) искусственного интеллекта.

Социально-экономические и этические аспекты внедрения «сильного» искусственного интеллекта

Человеческий мозг представляет собой сложнейшую нейронную сеть, функционирующую на основе протекания сложнейших биохимических и электрических процессов [6] (Kukartseva (Glaser), Ivlev, Novik, 2021). Прогресс развития систем ИИ в последнее время связан с применением технологий глубокого обучения нейросети. Данный подход состоит в том, что нейронные сети объединяются в единую систему, при этом каждый отдельный слой нейронов – из огромного количества слоев, построенных на базе определенных и регулярных паттернов. Следует отметить, что применение нейронных сетей является одной из наиболее эффективных технологий в сфере машинного глубокого обучения в целях решения многочисленных задач и проблем, ранее решавшихся неэффективно и неудовлетворительно.

В подтверждение гипотезы о вынужденном замораживании процессов создания «сильного» искусственного интеллекта («зимы» ИИ) приведем аргументацию д.б.н., проф. С.В. Савельева. Савельевым С.В. отмечается ряд факторов, которые серьезным образом тормозят развитие систем «сильного» ИИ, а возможно, делают данный процесс практически нереализуемым. В частности, ученым отмечается низкий уровень роста развития отрасли электроники, где усилия специалистов нацелены на процессы увеличения объемов памяти электронных устройств, скорости обмена информацией, повышения тактовой частоты, и указанные параметры демонстрируют практически предельно достигнутые значения [8]. «В настоящее время под искусственным интеллектом принято понимать процесс алгоритмизации больших баз данных. Однако это в корне неверная парадигма» [10, c. 12] (Savelev, 2018, р. 12).

Одним из наиболее весомых факторов, препятствующих эффективным разработкам алгоритмов сверхинтеллекта, по мнению ученого, является гипотеза о возможности физического упрощения работы мозга человека и компьютерного моделирования нейронных сетей. Попытки такого моделирования с помощью суперкомпьютеров в силу специфических биологических особенностей работы человеческого мозга завершаются полной неудачей [10, 13] (Savelev, 2018; Khamdamov, 2021). Экспертами в области изучения мозга показано, что «…информация на молекулы ДНК не записывается. Это глубочайшее заблуждение … Память – это система связей, не алгоритмизированный процесс, а реальный морфогенез» [10] (Savelev, 2018). В этой связи для создания сильного ИИ в алгоритм необходимо заложить нейронные связи, которые только будут формироваться и сформируются в обязательном порядке. В этом заключается наибольшая, пока непреодолимая для человеческой цивилизации проблема.

Подводя итоги научного исследования, отмечаем, что под «сильным» ИИ следует понимать способность цифрового компьютерного алгоритма выполнять сложные многоуровневые задачи, которые обычно связаны с жизнедеятельностью индивида [3] (Gorodnova, 2021). Данная дефиниция применима к проектам разработки систем, характеризующихся наличием интеллектуальных процессов, свойственных человеку, таких как способность к размышлению, рассуждению, анализу, систематизации, интерпретации и обучению на основе полученного индивидом опыта. Иными словами, «сильный» ИИ – это максимально приближенное отображение работы нейронных связей в мозге человека, отождествляемое с комплексами таких технологий и процессов, как глубокое машинное обучение и применение алгоритмов виртуальной реальности.

В настоящее время реализация идеи о создании систем искусственного сверхинтеллекта, кроме вышеуказанных ограничений, сталкивается с непреодолимыми фундаментальными физическими ограничениями.

Во-первых, скорость передачи сигнала в электронных системах ограничивается скоростью света. Учитывая законы квантовой механики и такие научные гипотезы, как теория Планка, неопределенность Гейзенберга и первый фундаментальный предел Бремерманна, отсюда следует ограничение на максимальную скорость машинных вычислений для автономной системы [9].

Во-вторых, необходимо учитывать другой предел возможностей ИИ, связанный с работой принципа Ландауэра о минимальном количестве тепла, которое выделяется в процессе обработки 1 бита информационного потока. Время для решения многоуровневых интеллектуальных задач является экспоненциальной функцией от размерности задачи. В этой связи обработка огромных массивов данных и скорость такой обработки теоретически могут вызывать подъем температуры до недопустимого уровня, что незамедлительно приведет к разрушению самой системы. На основании приведенных аргументов автор делает вывод о том, что в ближайшем обозримом будущем у человечества нет работающих оснований и возможностей для создания сильного искусственного интеллекта. Можно ожидать продвижения и совершенствования слабого ИИ, позволяющего разрабатывать машинные алгоритмы, существенно превышающие возможности человеческого интеллекта в рамках решения простых интеллектуальных задач.

Необходимо признать, что один из существенных выводов, вытекающих из проведенного исследования, состоит в следующем: для современной человеческой цивилизации разработка и внедрение единого универсального многозадачного искусственного интеллекта представляется пока нерешаемой задачей. Человеческий мозг развивался и продолжает развиваться в условиях непредсказуемости, неопределенности и риска. Это означает, что человечеству приходится постоянно сталкиваться с решением целого каскада нетривиальных задач, описать и запрограммировать которые не представляется возможным. Наиболее практичным и эффективным решением, признающимся экспертным сообществом, является развитие узкоспециализированного искусственного интеллекта, а также разработка и повышение мощностей каждой отдельной программы в системе ИИ, нацеленной на решение каждой конкретной задачи. Такие системы, как продукт функционирования современной IT-сферы, стали бы незаменимыми помощниками для человека во многих отраслях знаний и профессий. Однако работы по созданию сильного общего искусственного интеллекта (general artificial intelligence) [10] продолжаются, и разработки в данном направлении ведутся в ряде мировых исследовательских институтов. Сильный ИИ, по прогнозам специалистов, появится не ранее 2040–2075 гг.

В преддверии проведения Генеральной конференции ЮНЕСКО в ноябре 2021 года [11] процессы трансформации и осмысления морально-этических аспектов, связанных с разработкой и внедрением систем «сильного» искусственного интеллекта, приобретают еще большую актуальность. Ожидается, что в ходе указанной конференции будут разработаны и утверждены Рекомендации для государств – членов ЮНЕСКО, направленные на защиту прав человека в ходе цифровой трансформации экономики и внедрения алгоритмов ИИ в производственные и бизнес-процессы. Кроме того, указанные Рекомендации будут содержать направления решений проблем в сфере транспарентности и конфиденциальности цифровых данных, а также глобальную основу для развития цифрового права в рамках государственного регулирования различных аспектов использования искусственного интеллекта. Регулирование систем ИИ направлено на определение фундаментального ориентира в целях контроля уровня рисков и оценки перспективных возможностей использования ИИ для блага всего человечества [14] (Khrapov, Baeva, 2021).

Еще раз подчеркнем, что создание и внедрение так называемого сильного искусственного интеллекта следует ожидать в 30–45-летней перспективе. Однако уже сегодня необходимо сформулировать и осмыслить основные этические проблемы, которые сопровождают рассматриваемый процесс [9] (Razin, 2021).

К первой группе проблем следует отнести проблемы, связанные с «поражением прав» ИИ (Этично ли использовать ИИ, если он будет чувствовать боль? Будет ли ИИ чувствовать, например, одиночество или иные эмоции? Этично ли использовать ИИ в качестве домашнего животного и/или домашнего помощника?) [12] (Sinitsa, 2015). В этой сфере заложено огромное количество противоречий и сложных, пока неразрешимых вопросов, на которые у человечества нет однозначных ответов.

Вторая группа проблем, на наш взгляд, связана с возможным «поражением прав» человечества и отдельно взятого человека в условиях цифровизации и алгоритмизации. Уже сегодня идет процесс сокращения перечня привычных для человека профессий и вытеснение работника с рынка труда. Это негативные последствия включения в нашу повседневную жизнь алгоритмов «слабого» искусственного интеллекта.

По прогнозам экспертов, в результате бурного развития нейронных сетей и расширения перспектив использования искусственного интеллекта в течение 10–15 ближайших лет около 70–75% работников рискуют лишиться своих рабочих мест вследствие вытеснения их с рынка труда различного рода чат-ботами и алгоритмами ИИ [14] (Khrapov, Baeva, 2021). Ожидается, что, с одной стороны, данный процесс будет способствовать снижению так называемых транзакционных издержек производства на содержание персонала компаний и организаций, и это позитивный экономический эффект для производства и бизнеса. С другой стороны, данный процесс приведет к резкому сокращению общего объема трудовых ресурсов, занятых в производстве и сфере услуг, и постепенному исчезновению привычных человеку профессий за счет внедрения различных онлайн-алгоритмов. В первую очередь данный процесс затронет рынки труда, связанные с оказанием посреднических услуг: туроператор (2025 г.), помощник юриста (2026 г.), бухгалтер (2028 г.), сотрудник автостоянки (2028 г.), переводчик (2038 г.), водитель такси (2038 г.) [12].

По прогнозам аналитиков журнала «The Еconomist», к 2024 году около 80% англичан лишатся рабочих мест по причине их замены на производственных роботов [13].

Отдельной проблемой, по нашему мнению, является отсутствие нормативно-правовой базы (так называемого «цифрового» права), определяющей субъектность/объектность искусственного интеллекта, прав и обязанностей всех участников цифрового взаимодействия и пр. Это тема запланированного автором отдельного глубокого и всестороннего научного исследования.

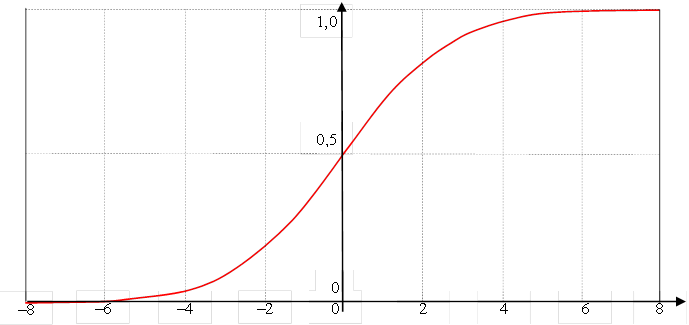

К вышеперечисленным аспектам этической проблемы, связанной с внедрением слабого ИИ, в будущем добавятся проблемы, относящиеся к вытеснению человека не только с рынка труда, но и возникновению риска повсеместного ограничения людей в их правах и глобальной угрозы доминирования искусственного интеллекта над естественным разумом [4] (Dudin, Shkodinskiy, 2021). Указанные процессы могут протекать по экспоненциальной функциональной зависимости. Однако необходимо подчеркнуть, что в вопросах внедрения «сильного» ИИ человечество пока располагается в левой части графика логистической кривой [14] (см. рис. 1).

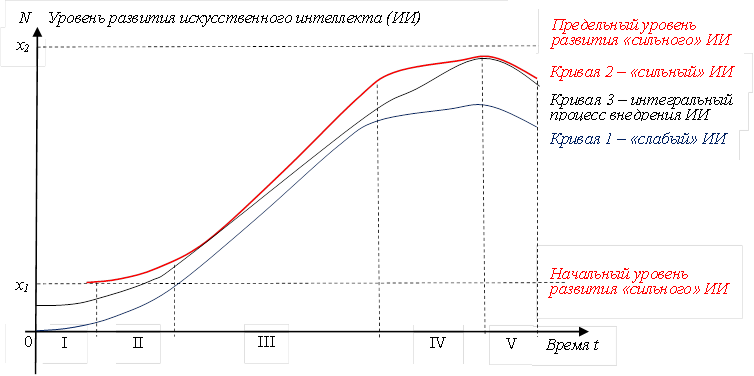

В ходе научного исследования автором предлагается способ прогностической оценки последствий включения в социум сильного искусственного интеллекта. Пусть конечное число потребителей программных продуктов и алгоритмов искусственного интеллекта – N; количество потребителей, включивших системы ИИ в производственные и бизнес-процессы, – x в течение промежутка времени t.

Рисунок 1. Кривая нормального распределения

Источник: построено автором по: Кривая нормального распределения (Гаусса) в Excel. – [Электронный ресурс]. – Режим доступа: https://statanaliz.info/statistica/teoriya-veroyatnostej/normalnoe-raspredelenie-v-excel/ (дата обращения: 11.07.2021 г.).

Тогда скорость внедрения продуктов, связанных с ИИ, может быть рассчитана по следующей формуле:

v = dx / dt = kI x (N – x), (1)

где kI – коэффициент информационной пропорциональности.

Граничные условия заданы следующим выражением:

x (0) = N / Ω (2)

Применение процедур разделения переменных и интегрирования частей уравнения позволяет получить следующе формулы:

dx / x (N – x) = kI dt. (3)

ʃ dx / x (N – x)= … 1/N (Ln (x / x – N) + C1. (4)

В целях сокращения представленных математических выражений аналогично интегрируем правую часть исходного уравнения и получаем выражение:

In (x / x – N)= N kI t + C, (5)

где С – константа.

Решая уравнение, исключая натуральные логарифмы, получим итоговую формулу для определения числа потребителей систем ИИ – x:

x = N / [1 + (Ω – 1)e-NkIt]. (6)

Данное конечное выражение дает возможность определить число потребителей алгоритмов ИИ за временной промежуток t. График зависимости изменения x – числа потребителей алгоритмов ИИ от периода времени t – функции x (t) представлен на рисунке 2.

Общество растущего Общество постоянных Общество падающего

потребления улучшений потребления

Рисунок 2. Логистическая кривая развития и внедрения систем «слабого» и «сильного» искусственного интеллекта

Источник: построено автором по формуле (6).

Комментарии к рисунку 2:

Кривая 1 – логистическая кривая развития «слабого» искусственного интеллекта:

I этап – зарождение и начало осуществления разработок в сфере «слабого» искусственного интеллекта.

Данный этап характеризуется экспериментальным характером развития систем «слабого» искусственного интеллекта, созданием имитационных моделей и алгоритмов узкого ИИ, достаточно небольшими финансовыми вложениями в процессы разработки и апробации систем ИИ, небольшим количеством IT-компаний в экономически развитых странах, небольшим числом потребителей систем ИИ – x, что соответствует слабому уровню конкуренции на рынке IT-услуг, а следовательно, отсутствием бизнес-ниш для внедрения программных продуктов, а также нормативов и стандартов. Основным критерием эффективности 1-го этапа развития ИИ является наличие креативных идей специалистов в области IT-технологий и нейронных сетей.

II этап – развитие алгоритмов «слабого» ИИ. Для данного этапа развития слабого ИИ характерны рост числа потребителей x и рост спроса на программные продукты и алгоритмы, связанные с системами искусственного интеллекта, формируются микрониши, в рамках которых осуществляется продвижение ИИ в бизнес-сферу, начинают формироваться стандарты и нормативно-правовая основа реализации систем ИИ, предоставляется относительная доступность продуктов ИИ. Главным критерием эффективности разработок на данном этапе является поиск возможности оптимизации затрат на разработки и внедрение ИИ.

III этап – широкое внедрение алгоритмов и систем «слабого» ИИ в производство и бизнес-процессы. Рассматриваемому этапу развития слабого ИИ свойственны наличие стандартизированного и унифицированного правового поля, наблюдается широкое внедрение алгоритмов ИИ в производственные и социально-экономические процессы, отсутствие новых прорывных идей для усовершенствования имеющихся разработок и систем ИИ и высокий уровень конкурентной борьбы за потребителя x. Основным критерием эффективности является вектор на экономию и поиск удачных маркетинговых решений, поскольку рынок IT- и smart-технологий насыщен, возможности роста рынка и продвижения продуктов ИИ не просматриваются.

IV этап – замедление темпов внедрения и использования систем «слабого» ИИ. На данном этапе предположительно будет наблюдаться потеря интереса потребителей x к алгоритмам слабого искусственного интеллекта при условии полного насыщения рынка или появления адекватной замены. Здесь следует подчеркнуть, что на данном этапе возможно вытеснение слабого ИИ с рынка продуктами «сильного» искусственного интеллекта. В рамках закона отрицания возможно возникновение так называемой узкой специализации и повышенного спроса на результаты естественного интеллекта и ручной человеческий труд.

V этап – разрушение и регресс процесса внедрения «слабого» ИИ. Развитие искусственного интеллекта достигает предельно возможного для данной человеческой цивилизации уровня N. По нашему мнению, данный этап может стать началом нового диалектического цикла развития IT-технологий и технологий разработок систем искусственного интеллекта.

Кривая 2 и 3 – логистические кривые, динамики развития, соответственно, «сильного» и общего ИИ и включения его в повседневную жизнь человеческого общества.

Следует отметить, что, несмотря на отсутствие единого общепринятого определения дефиниции «искусственный интеллект», завершенного понятийно-категориального аппарата и терминологических классификаций, в процессе перехода к новому информационному обществу и цифровой экономике многими экономически развитыми государствами осуществляются крупномасштабные инвестиционные вложения в целях разработки и внедрения систем искусственного интеллекта и технологической конвергенции.

Заключение

Подводя итоги всему вышеизложенному, можно сделать вывод, что искусственный интеллект (ИИ) – это не просто программы или алгоритмы, которые способны предоставлять, как нам покажется, удачные и логичные ответы на шаблонно поставленные вопросы. По идее изобретателей, искусственный интеллект – это мощнейший инструмент, позволяющий автоматизировать функционирование машин и механизмов в различных отраслях производства и бизнеса. При этом необходимо четко разграничить понятие «слабого» и «сильного» искусственного интеллекта, а также идентифицировать позитивные и негативные последствия внедрения узкого (слабого) ИИ [11] (Savchuk, Ocheretyanyy, 2021), поскольку любая сложная технология, претендующая на определенное место в общественном ландшафте, бесспорно, является источником специфических рисков и угроз безопасности человечества, к примеру, в рамках применения медицинских диагностических интеллектуальных систем.

Несмотря на имеющиеся положительные ожидаемые последствия реализации стратегии российского государства на оцифровывание всех имеющихся у человечества знаний и информации, а также применения систем слабого искусственного интеллекта, проблема адаптации и поиска себя, своего места и смысла в жизни каждого конкретного индивида приобретает все возрастающее значение. Проблема идентификации человека в мире цифр и антропоморфных роботов из философского осмысления переводит в новый пласт – психолого-экономический. Возникновение оцифрованного мира и цифровых экономик ставит перед нами вопрос: необходимо, чтобы цифровые технологии и алгоритмические системы служили человеку, но не поработили его.

[1]Словами специалиста: вся правда об искусственном интеллекте: – [Электронный ресурс]. – Режим доступа: https://newtonew.com/tech/slovami-specialista-vsya-pravda-ob-iskusstvennom-intellekte (дата обращения 06.07.2021 г.),

[2]Искусственный разум и его имитация: есть ли разница. – [Электронный ресурс]. – Режим доступа: https://author.today/post/33000 (дата обращения: 05.07.2021 г.).

[3]Обучение нейросети с учителем, без учителя, с подкреплением – в чем отличия? Какой алгоритм лучше? – [Электронный ресурс]. – Режим доступа: https://neurohive.io/ru/osnovy-data-science/obuchenie-s-uchitelem-bez-uchitelja-s-podkrepleniem/ (дата обращения: 09.07.2021 г.).

[4] Обучение нейросети с учителем, без учителя, с подкреплением – в чем отличия? Какой алгоритм лучше? – [Электронный ресурс]. – Режим доступа: https://neurohive.io/ru/osnovy-data-science/obuchenie-s-uchitelem-bez-uchitelja-s-podkrepleniem/ (дата обращения: 09.07.2021 г.).

[5] Там же.

[6] ИИ: имитации интеллекта, обман и реальные достижения. – [Электронный ресурс]. – Режим доступа: https://se7en.ws/ii-imitaciya-intellekta-obman-i-realn/ (дата обращения 07.07.2021 г.).

[7] Там же.

[8]Савельев С.В. Абстракции искусственного интеллекта. – [Электронный ресурс]. – Режим доступа: https://www.youtube.com/watch?v=aL1uTwD6860 (дата обращения: 15.07.2021 г.).

[9] Система искусственного интеллекта будет определять успех фильма. – [Электронный ресурс]. – Режим доступа: https://kupihome.ru/podklyuchenie/sistema-iskusstvennogo-intellekta-budet-opredelyat-uspeh-filma.html (дата обращения: 09.07.2021 г.).

[10] Философы – о том, какой искусственный интеллект нам нужен? – [Электронный ресурс]. – Режим доступа: https://knife.media/cyberphilosophy-ai/ (дата обращения: 08.07.2021 г.).

[11]Этические аспекты искусственного интеллекта. – [Электронный ресурс]. – Режим доступа: https://www.russianireland.com/jeticheskie-aspekty-iskusstvennogo-intellekta/ (дата обращения: 10.07.2021 г.).

[12]Составлено автором по: Атлас новых профессий. – [Электронный ресурс]. – Режим доступа: https://new.atlas100.ru/ (дата обращения: 01.03.2021 г.).

[13]The economist (Великобритания): радужные перспективы на рынке труда. – [Электронный ресурс]. – Режим доступа: https://inosmi.ru/politic/20210413/249546450.html (дата обращения: 14.07.2021 г.).

[14] Маланов А. Этические вопросы искусственного интеллекта. – [Электронный ресурс]. – Режим доступа: https://habr.com/ru/company/kaspersky/blog/421791/ (дата обращения: 10.07.2021 г.).

Источники:

2. Воронцова И.В., Луконина Ю.А. Дефиниция «искусственный интеллект» и ее семантико-процессуальное значение в судебной системе России и зарубежных стран // Российский судья. – 2020. – № 10. – c. 41-45. – doi: 10.18572/1812-3791-2020-10-41-45 .

3. Городнова Н.В. Моделирование рынка цифровых валютных активов: экономико-правовые аспекты // Экономические отношения. – 2021. – № 3. – c. 583-602. – doi: 10.18334/eo.11.3.112277 .

4. Дудин М.Н., Шкодинский С.В. Тенденции, возможности и угрозы цифровизации национальной экономики в современных условиях // Экономика, предпринимательство и право. – 2021. – № 3. – c. 689-714. – doi: 10.18334/epp.11.3.111785 .

5. Жилин В.В., Сафарьян О.А. Искусственный интеллект в системах хранения данных // Вестник Донского государственного технического университета. – 2020. – № 2. – c. 196-200. – doi: 10.23947/1992-5980-2020-20-2-196-200 .

6. Кукарцева (Гласер) М. А., Ивлев В.Ю., Новик Н.Н. Дискурсы биополитики и безопасности человека в условиях новых вызовов и угроз человечеству // Вопросы философии. – 2021. – № 2. – c. 42-52. – doi: 10.21146/0042-8744-2021-2-42-52 .

7. Лапаев Д.Н., Морозова Г.А. Искусственный интеллект: за и против // Развитие и безопасность. – 2020. – № 3(7). – c. 70-77. – doi: 10.46960/2713-2633_2020_3_70 .

8. Любимов А.П. Основные подходы к определению понятия «искусственный интеллект» // Научно-техническая информация. Серия 2: Информационные процессы и системы. – 2020. – № 9. – c. 1-6. – doi: 10.36535/0548-0027-2020-09-1 .

9. Разин А.В. Этика искусственного интеллекта // Философия и общество. – 2021. – № 1. – c. 1-17.

10. Савельев С.В. Морфология сознания. / В 2 т. Т.1. - М.: ВЕДИ, 2018. – 208 c.

11. Савчук В.В., Очеретяный К.А. Цифровой поворот: глобальные тенденции и локальные специфики // Вопросы философии. – 2021. – № 4. – c. 5-16. – doi: 10.21146/0042-8744-2021-4-5-16 .

12. Синица А.С. Морально-этические аспекты теории искусственного интеллекта // Молодой ученый. – 2015. – № 18(98). – c. 419-423.

13. Хамдамов Т.В. Компьютерный поворот в философии XXI в. (размышления над книгой Йоханнеса Ленхарда «Сюрпризы вычислений. Философия компьютерных симуляций) // Вопросы философии. – 2021. – № 5. – c. 36-46. – doi: 10.21146/0042-8744-2021-5-36-46 .

14. Храпов С.А., Баева Л.В. Философия рисков цифровизации образования: когнитивные риски и пути создания безопасной коммуникативно-образовательной среды // Вопросы философии. – 2021. – № 4. – c. 17-26. – doi: 10.21146/0042-8744-2021-4-17-26 .

Страница обновлена: 04.01.2026 в 14:49:01

Download PDF | Downloads: 71 | Citations: 3

Modeling the development and implementation of "weak" and "strong" artificial intelligence systems: socio-economic aspects

Gorodnova N.V.Journal paper

Russian Journal of Innovation Economics

Volume 12, Number 1 (January-March 2022)

Abstract:

The process of implementing the national program "Digital Economy of the Russian Federation" is accompanied by the active introduction of artificial intelligence (AI) algorithms into various spheres of the domestic economy. In this regard, the topic of scientific research is recognized as relevant and important.

The purpose of this article is to identify and study the socio-economic and ethical aspects of the inclusion of artificial intelligence algorithms in the life of a person and society as a whole. The scientific novelty lies in the differentiation of the definition of "weak" and "strong" artificial intelligence, the development of the conceptual and categorical apparatus by clarifying individual definitions, as well as the use of separate approaches of economic and mathematical modeling in predicting the level of inclusion of AI capabilities in human society.

The practical significance of the study consists in determining the factors constraining the development of the so-called "strong" artificial intelligence (superintelligence), as well as in identifying socio-economic and ethical problems of the introduction of AI in various spheres of socio-economic life. The results of scientific research can be useful to specialists in IT and business spheres, as well as scientists dealing with economic, socio-humanitarian and ethical problems of extended reproduction of artificial intelligence systems.

Keywords: artificial intelligence, morphogenesis, neural networks, ethics, transaction costs, labour market, self-learning

JEL-classification: O31, O32, O33

References:

Bykov V.A. (2020). Iskusstvennyy intellekt kak istochnik politicheskikh suzhdeniy [Artificial intelligence as a source of political thinking]. Zhurnal politicheskikh issledovaniy. 4 (2). 23-33. (in Russian). doi: 10.12737/2587-6295-2020-23-33 .

Dudin M.N., Shkodinskiy S.V. (2021). Tendentsii, vozmozhnosti i ugrozy tsifrovizatsii natsionalnoy ekonomiki v sovremennyh usloviyakh [Trends, opportunities and threats of digitalization of the national economy in modern conditions]. Journal of Economics, Entrepreneurship and Law. 11 (3). 689-714. (in Russian). doi: 10.18334/epp.11.3.111785 .

Gorodnova N.V. (2021). Modelirovanie rynka tsifrovyh valyutnyh aktivov: ekonomiko-pravovye aspekty [Modeling of the digital currency assets market: economic and legal aspects]. Journal of International Economic Affairs. 11 (3). 583-602. (in Russian). doi: 10.18334/eo.11.3.112277 .

Khamdamov T.V. (2021). Kompyuternyy povorot v filosofii XXI v. (razmyshleniya nad knigoy Yokhannesa Lenkharda «Syurprizy vychisleniy. Filosofiya kompyuternyh simulyatsiy) [Computer turn in the philosophy of the XXI century (reflection on the book “Calculated surprises. A philosophy of computer simulation” by Johannes Lenhard)]. Russian Studies in Philosophy. (5). 36-46. (in Russian). doi: 10.21146/0042-8744-2021-5-36-46 .

Khrapov S.A., Baeva L.V. (2021). Filosofiya riskov tsifrovizatsii obrazovaniya: kognitivnye riski i puti sozdaniya bezopasnoy kommunikativno-obrazovatelnoy sredy [Risk philosophy of education digitalization: cognitive risks and ways to create a secure communicative educational environment]. Russian Studies in Philosophy. (4). 17-26. (in Russian). doi: 10.21146/0042-8744-2021-4-17-26 .

Kukartseva (Glaser) M. A., Ivlev V.Yu., Novik N.N. (2021). Diskursy biopolitiki i bezopasnosti cheloveka v usloviyakh novyh vyzovov i ugroz chelovechestvu [Discourses of biopolitics and human security in the context of new challenges and threats to humanity]. Russian Studies in Philosophy. (2). 42-52. (in Russian). doi: 10.21146/0042-8744-2021-2-42-52 .

Lapaev D.N., Morozova G.A. (2020). Iskusstvennyy intellekt: za i protiv [Artificial intelligence: pros and cons]. Razvitie i bezopasnost. (3(7)). 70-77. (in Russian). doi: 10.46960/2713-2633_2020_3_70 .

Lyubimov A.P. (2020). Osnovnye podkhody k opredeleniyu ponyatiya «iskusstvennyy intellekt» [Main approaches to the definition of «artificial intelligence»]. Nauchno-tekhnicheskaya informatsiya. Seriya 2: Informatsionnye protsessy i sistemy. (9). 1-6. (in Russian). doi: 10.36535/0548-0027-2020-09-1 .

Razin A.V. (2021). Etika iskusstvennogo intellekta [Ethics of artificial intelligence]. Filosofiya i obschestvo. (1). 1-17. (in Russian).

Savchuk V.V., Ocheretyanyy K.A. (2021). Tsifrovoy povorot: globalnye tendentsii i lokalnye spetsifiki [Digital turn:global trends and local specifics]. Russian Studies in Philosophy. (4). 5-16. (in Russian). doi: 10.21146/0042-8744-2021-4-5-16 .

Savelev S.V. (2018). Morfologiya soznaniya [Morphology of consciousness] M.: VEDI. (in Russian).

Sinitsa A.S. (2015). Moralno-eticheskie aspekty teorii iskusstvennogo intellekta [Moral and ethical aspects of the theory of artificial intelligence]. The young scientist. (18(98)). 419-423. (in Russian).

Vorontsova I.V., Lukonina Yu.A. (2020). Definitsiya «iskusstvennyy intellekt» i ee semantiko-protsessualnoe znachenie v sudebnoy sisteme Rossii i zarubezhnyh stran [The definition artificial intelligence and its semantic and procedural meaning in the judicial system of Russia and foreign countries]. Rossiyskiy sudya. (10). 41-45. (in Russian). doi: 10.18572/1812-3791-2020-10-41-45 .

Zhilin V.V., Safaryan O.A. (2020). Iskusstvennyy intellekt v sistemakh khraneniya dannyh [Artificial intelligence in data storage systems]. Vestnik of DSTU. 20 (2). 196-200. (in Russian). doi: 10.23947/1992-5980-2020-20-2-196-200 .